Subunidade - Texto

Padrões de codificação de caracteres

Os padrões de formatação de caracteres descrevem o relacionamento entre o conjunto de caracteres com um conjunto de outra coisa, por exemplo, impulsos elétricos ou números com o objetivo de facilitar o armazenamento de texto em computadores e a sua transmissão através de redes de telecomunicação. Os exemplos mais comuns são o código ASCII e Unicode.O ASCII é um código que foi proposto por Robert W. Bemer como uma solução para unificar a representação de caracteres alfanuméricos em computadores. Antes de 1960 cada computador utilizava uma regra diferente para representar estes caracteres e o códigoASCII nasceu para se tornar comum entre todas as máquinas.O nome ASCII vem do inglês American Standard Code for Information Interchange ou ”Código Padrão Americano para o Intercâmbio de Informação”. Ele é baseado no alfabeto romano e sua função é padronizar a forma como os computadores representam letras, números, acentos, sinais diversos e alguns códigos de controlo. O Unicode é um código que define todos os caracteres da maior parte das línguas do mundo. Foi desenvolvido, em simultâneo, por um consórcio industrial, incluindo, entre outras companhias, a Adobe, a Apple, a Microsoft, a HP, a IBM, a Grae/e, a SAP, a SUN e a Unisys. É um sistema de codificação de caracteres projetado para suportar o intercâmbio, processamento e exibição a nível mundial dos textos escritos nas diversas línguas e disciplinas técnicas do mundo moderno. Além disso, ele suporta textos clássicos e históricos de idiomas escritos nas mais variadas línguas.

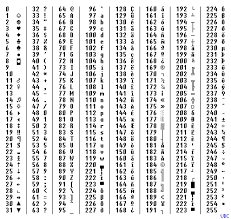

ASCII significa “American Standard Code for Information Interchange ”(Código Padrão Americano para Intercâmbio de Informações), e consiste em uma tabela de códigos (criada na década de 60) utilizada pelos computadores para representar caracteres no formato numérico (binário), que é o formato padrão utilizado para armazenamento e processamento dos dados. Desta forma, cada caracteres presente em um teclado, e mais um conjunto de outros caracteres, como letras “a”, “r”, números “6′, “9”, ou ainda símbolos, como “%”, “&”, entre outros, podem ser representados por um conjunto de oito bits (um byte) na memória do computador. Alguns caracteres não-imprimíveis também são representados na tabela ASCII, como por exemplo as teclas TAB, ESC e Backspace.Abaixo temos a tabela de caracteres em ASCII original, incluindo os valores numéricos de cada caracteres em decimal, binário, octal ehexadecimal. Nota que letras maiúsculas e minúsculas são consideradas caracteres diferentes entre si, cada uma com seu próprio código ASCII. Além disso, podemos perceber que a tabela original ASCII utiliza sete bits para representar os caracteres, sendo que o oitavo bit (à esquerda, MSB) é sempre zero.

Código Unicode

Unicode é um padrão universal de codificação de caracteres que é usado para suportar caracteres em scripts não-ASCII. A internet foi construída originalmente em ASCII, que se baseia no alfabeto inglês e consiste em apenas 128 caracteres. O Unicode oferece suporte a todas as línguas em todo o mundo com seus conjuntos de caracteres únicos - o Unicode pode suportar mais de 1 milhão de caracteres! Ele atua permitindo mais bits que são unidades de informações em uma máquina. Os caracteres ASCII requerem apenas cerca de 7 bits, enquanto o Unicode usa 16 bits. Isso é necessário porque é preciso mais bits para processar idiomas como o chinês, árabe e russo. Existem diferentes tipos de Unicode, incluindo UTF-8 e UTF-16, os dois mais comuns. O UTF-8 tornou-se o padrão típico usado na web porque ele ajusta o número de bits usados dependendo do caractere. Isso significa que os caracteres ASCII no UTF-8 apenas ocupam os bits que precisam processar.

Comentários

Enviar um comentário